Compart Magazine

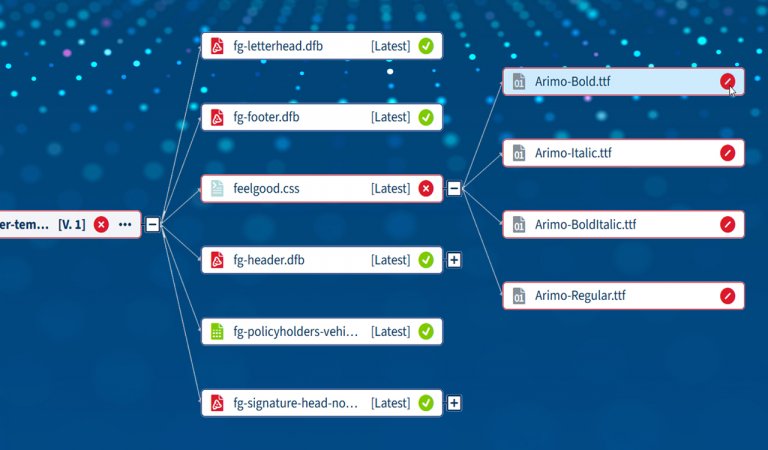

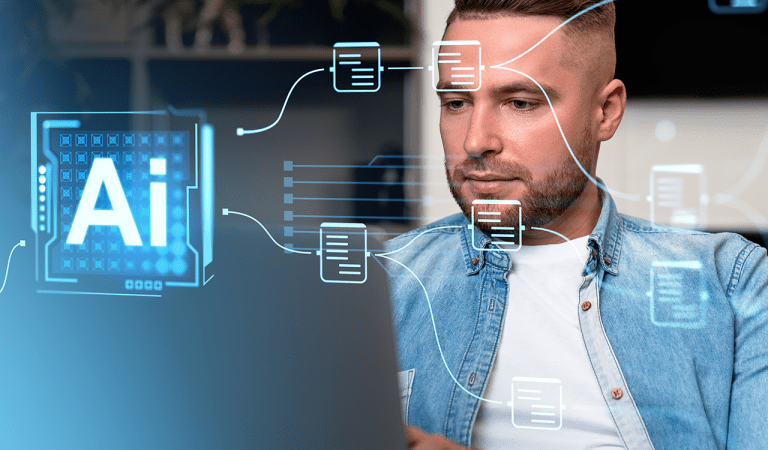

Architecture et technologieMigration de modèles assistée par IA dans la DocBridge® Communication Suite

Accélérez votre passage vers un CCM moderne : migrez de grands volumes de modèles PDF avec précision, de façon automatisée et fluide grâce à la DocBridge® Communication Suite

Plus